- Hyperlink läuft vollständig auf lokaler Hardware, sodass jede Suche privat bleibt

- Die App indiziert innerhalb von Minuten riesige Datenordner auf RTX-PCs

- Mit der neuesten Optimierung von Nvidia verdoppelt sich die Geschwindigkeit der LLM-Inferenz auf Hyperlink

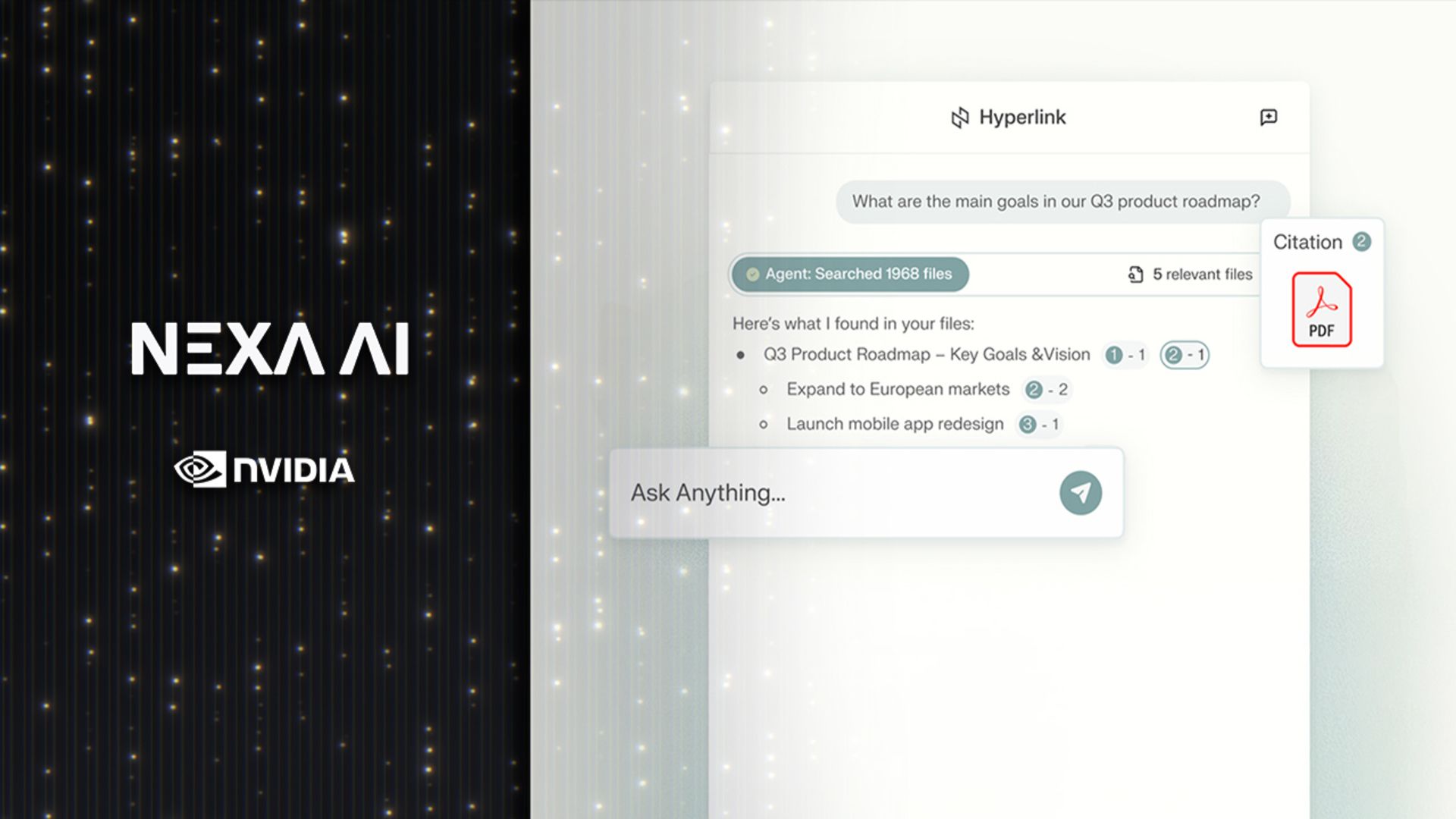

Der neue „Hyperlink“-Agent von Nexa.ai führt einen Ansatz zur KI-Suche ein, der vollständig auf lokaler Hardware läuft.

Die für Nvidia RTX AI-PCs entwickelte App fungiert als geräteinterner Assistent, der persönliche Daten in strukturierte Erkenntnisse umwandelt.

Nvidia erläuterte, wie es alles lokal verarbeitet, anstatt Anfragen an Remote-Server zu senden, und so sowohl Geschwindigkeit als auch Datenschutz bietet.

Private Geheimdienste mit lokaler Geschwindigkeit

Hyperlink wurde auf einem RTX 5090-System getestet, wo es Berichten zufolge im Vergleich zu früheren Builds eine bis zu dreimal schnellere Indizierung und eine doppelt so hohe Inferenzgeschwindigkeit für große Sprachmodelle liefert.

Diese Kennzahlen deuten darauf hin, dass damit Tausende von Dateien auf einem Computer effizienter gescannt und organisiert werden können als mit den meisten vorhandenen KI-Tools.

Hyperlink gleicht nicht nur Suchbegriffe ab, sondern interpretiert die Absicht des Benutzers, indem er die Argumentationsfähigkeiten von LLMs auf lokale Dateien anwendet, sodass relevantes Material auch dann gefunden werden kann, wenn Dateinamen unklar sind oder keinen Bezug zum tatsächlichen Inhalt haben.

Dieser Wandel von der statischen Stichwortsuche hin zum kontextbezogenen Verständnis steht im Einklang mit der zunehmenden Integration generativer KI in alltägliche Produktivitätstools.

Das System kann auch verwandte Ideen aus mehreren Dokumenten verknüpfen und so strukturierte Antworten mit klaren Referenzen bieten.

Im Gegensatz zu den meisten Cloud-basierten Assistenten speichert Hyperlink alle Benutzerdaten auf dem Gerät, sodass die gescannten Dateien, von PDFs und Folien bis hin zu Bildern, privat bleiben und sichergestellt wird, dass keine persönlichen oder vertraulichen Informationen den Computer verlassen.

Dieses Modell spricht Profis an, die mit sensiblen Daten umgehen und dennoch die Leistungsvorteile der generativen KI nutzen möchten.

Benutzer erhalten Zugriff auf schnelle kontextbezogene Antworten, ohne das Risiko einer Datenoffenlegung einzugehen, die mit der Fernspeicherung oder -verarbeitung einhergeht.

Die Optimierung von Nvidia für RTX-Hardware geht über die Suchleistung hinaus, da das Unternehmen behauptet, dass Retrieval-Augmented Generation (RAG) jetzt dichte Datenordner bis zu dreimal schneller indiziert.

Eine typische 1-GB-Sammlung, deren Verarbeitung früher fast 15 Minuten dauerte, kann jetzt in etwa 5 Minuten indiziert werden.

Die Verbesserung der Schlussfolgerungsgeschwindigkeit führt auch dazu, dass Antworten schneller erscheinen, wodurch alltägliche Aufgaben wie die Vorbereitung von Besprechungen, Lernsitzungen oder die Analyse von Berichten reibungsloser ablaufen.

Hyperlink verbindet Komfort mit Kontrolle, indem es lokales Denken und GPU-Beschleunigung kombiniert, was es zu einem nützlichen KI-Tool für Menschen macht, die ihre Daten privat halten möchten.

Folgen Sie TechRadar auf Google News Und Fügen Sie uns als bevorzugte Quelle hinzu um unsere Expertennachrichten, Rezensionen und Meinungen in Ihren Feeds zu erhalten. Klicken Sie unbedingt auf die Schaltfläche „Folgen“!

Und natürlich können Sie das auch Folgen Sie TechRadar auf TikTok für Neuigkeiten, Rezensionen, Unboxings in Videoform und erhalten Sie regelmäßige Updates von uns WhatsApp zu.