- Mit Raspberry Pi AI HAT+ 2 kann Raspberry Pi 5 LLMs lokal ausführen

- Der Hailo-10H-Beschleuniger liefert 40 TOPS INT4-Inferenzleistung

- Die PCIe-Schnittstelle ermöglicht eine Kommunikation mit hoher Bandbreite zwischen der Platine und dem Raspberry Pi 5

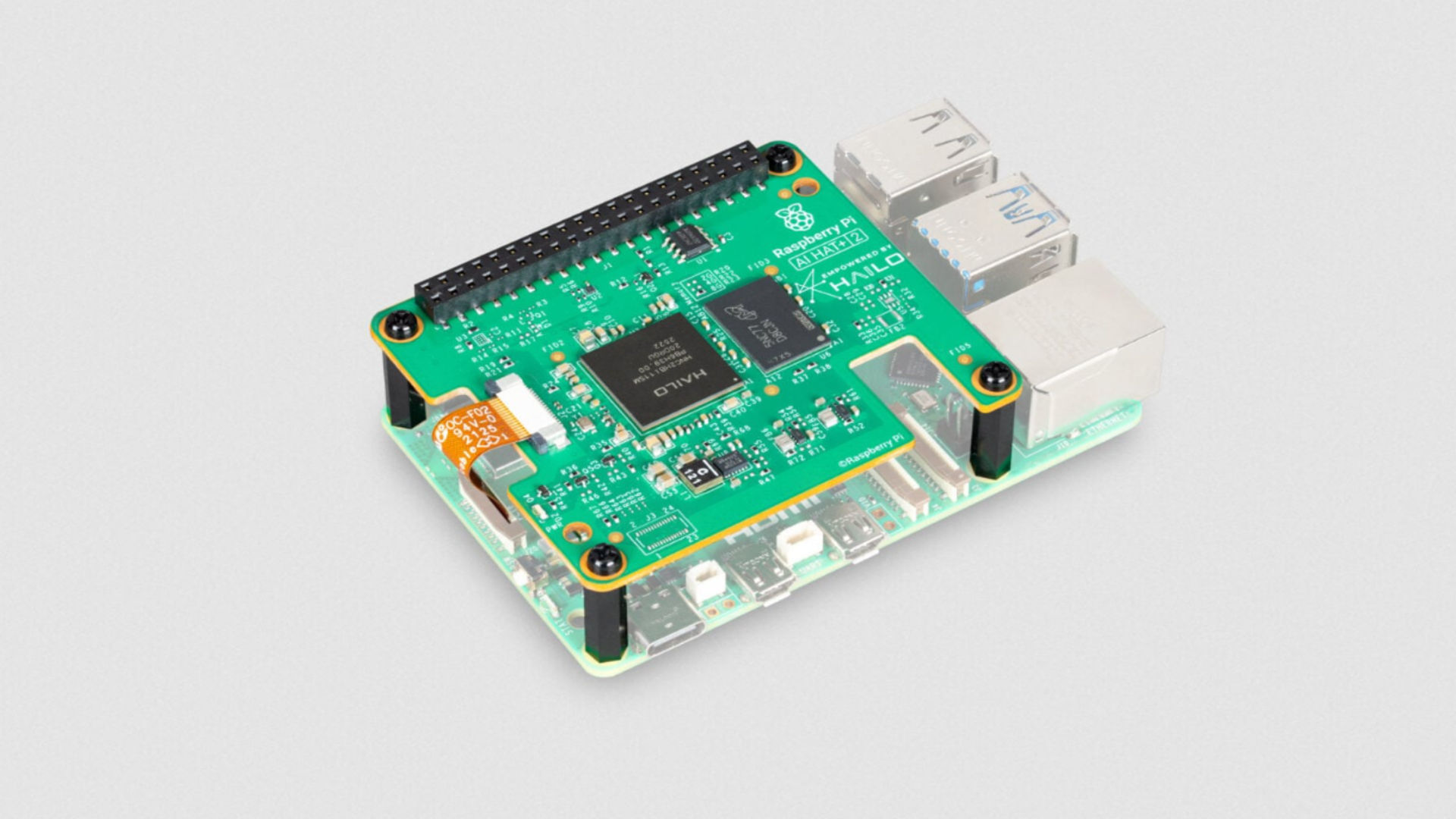

Raspberry Pi hat seine Edge-Computing-Ambitionen mit der Veröffentlichung des erweitert HAT+ 2ein Zusatzboard, das entwickelt wurde, um generative KI-Workloads auf den Raspberry Pi 5 zu bringen.

Frühere AI-HAT-Hardware konzentrierte sich fast ausschließlich auf die Beschleunigung von Computer Vision und erledigte Aufgaben wie Objekterkennung und Szenensegmentierung.

Der neue Vorstand erweitert diesen Rahmen durch Unterstützung große Sprachmodelle und Vision-Sprachmodelle, die lokal ausgeführt werden, ohne auf eine Cloud-Infrastruktur oder dauerhaften Netzwerkzugriff angewiesen zu sein.

Hardwareänderungen, die lokale Sprachmodelle ermöglichen

Im Zentrum des Upgrades steht der Beschleuniger für neuronale Netze Hailo-10H, der eine INT4-Inferenzleistung von 40 TOPS liefert.

Im Gegensatz zu seinem Vorgänger verfügt der AI HAT+ 2 über 8 GB dedizierten Onboard-Speicher, sodass größere Modelle ausgeführt werden können, ohne System-RAM auf dem Host-Raspberry Pi zu verbrauchen.

Diese Änderung ermöglicht die direkte Ausführung von LLMs und VLMs auf dem Gerät und gewährleistet eine geringe Latenz und lokale Daten, was eine wichtige Voraussetzung für viele Edge-Bereitstellungen ist.

Verwendung eines Standards Raspberry Pi-DistributionBenutzer können unterstützte Modelle installieren und über vertraute Schnittstellen wie browserbasierte Chat-Tools darauf zugreifen.

Der AI HAT+ 2 verbindet sich über den GPIO-Header mit dem Raspberry Pi 5 und nutzt für die Datenübertragung die PCIe-Schnittstelle des Systems, was eine Kompatibilität mit dem Raspberry Pi 4 ausschließt.

Diese Verbindung unterstützt die Datenübertragung mit hoher Bandbreite zwischen dem Beschleuniger und dem Host, was für die effiziente Übertragung von Modelleingängen, -ausgängen und Kameradaten unerlässlich ist.

Zu den Demonstrationen gehören textbasierte Fragenbeantwortung mit Qwen2, Codegenerierung mit Qwen2.5-Coder, grundlegende Übersetzungsaufgaben und visuelle Szenenbeschreibungen aus Live-Kamera-Feeds.

Diese Arbeitslasten sind abhängig KI-Tools verpackt, um innerhalb des Pi-Software-Stacks zu funktionieren, einschließlich containerisierter Backends und lokaler Inferenzserver.

Die gesamte Verarbeitung erfolgt auf dem Gerät, ohne externe Rechenressourcen.

Die unterstützten Modelle reichen von einer bis eineinhalb Milliarden Parametern, was im Vergleich zu Cloud-basierten Systemen, die in weitaus größeren Maßstäben arbeiten, bescheiden ist.

Diese kleineren LLMs zielen eher auf begrenzte Speicher- und Leistungsbereiche ab als auf umfassendes, allgemeines Wissen.

Um dieser Einschränkung zu begegnen, unterstützt AI HAT+ 2 Feinabstimmungsmethoden wie Low-Rank Adaptation, die es Entwicklern ermöglicht, Modelle für enge Aufgaben anzupassen und dabei die meisten Parameter unverändert zu lassen.

Vision-Modelle können auch mithilfe anwendungsspezifischer Datensätze über die Toolchain von Hailo neu trainiert werden.

Der AI HAT+ 2 ist für 130 US-Dollar erhältlich und liegt damit über früherem Vision-Zubehör und bietet gleichzeitig einen ähnlichen Computer-Vision-Durchsatz.

Für Workloads, die sich ausschließlich auf die Bildverarbeitung konzentrieren, bietet das Upgrade nur begrenzte Vorteile, da seine Attraktivität größtenteils auf der lokalen LLM-Ausführung und datenschutzrelevanten Anwendungen beruht.

In der Praxis zeigt die Hardware, dass generative KI auf Raspberry-Pi-Hardware mittlerweile machbar ist, obwohl begrenzter Speicherspielraum und kleine Modellgrößen weiterhin ein Problem darstellen.

Folgen Sie TechRadar auf Google News Und Fügen Sie uns als bevorzugte Quelle hinzu um unsere Expertennachrichten, Rezensionen und Meinungen in Ihren Feeds zu erhalten. Klicken Sie unbedingt auf die Schaltfläche „Folgen“!

Und natürlich können Sie das auch Folgen Sie TechRadar auf TikTok für Neuigkeiten, Rezensionen, Unboxings in Videoform und erhalten Sie regelmäßige Updates von uns WhatsApp zu.